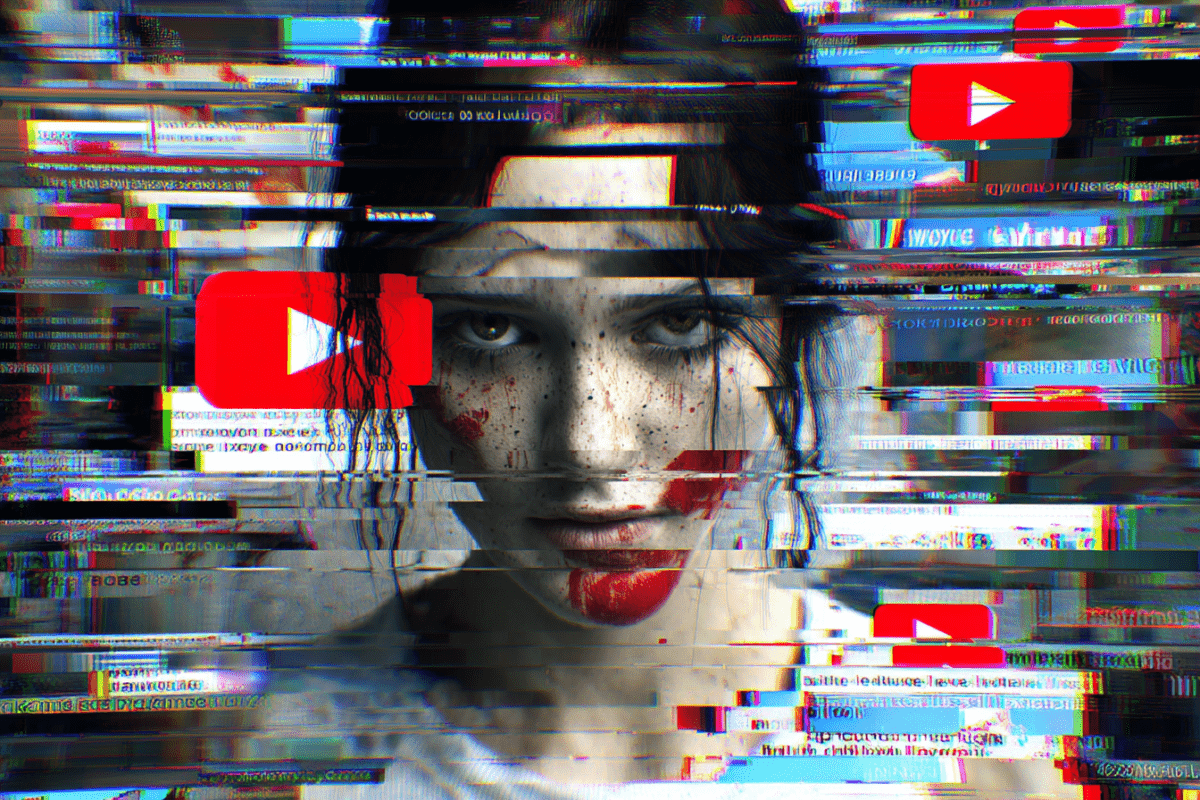

YouTube отключает монетизацию видео, сгенерированных нейросетями — и сам же страдает от своих инструментов

С 15 июля YouTube начнёт массово отключать монетизацию у видео, полностью созданных ИИ.Это коснётся контента с синтетическим голосом, deepfake-визуалом, а также «переупакованных» видео, которые ИИ выдает за новые.

Особое внимание — к жанру, превратившему Shorts в бесконтрольный поток фейковых историй. По данным The Verge, автоматические фильтры начнут проверять голос за кадром и искать повторяемость сцен. У подозрительных видео будет отключена реклама — даже если они собирают миллионы просмотров.

Почему YouTube решил «разгрести» свою же ИИ-помойку

Решение YouTube — реакция на резкую критику за «обрушение качества» в разделе Shorts. Один из примеров: вирусный ролик, где мопс спасает младенца после авиакатастрофы, собрал 400+ млн просмотров и стал символом эпохи алгоритмической абсурдности.

Теперь площадка пытается отмежеваться от собственного хаоса.

Но вот парадокс: Google активно развивает генеративные модели — включая Veo для видео и Gemini для текста. И теперь фактически наказывает авторов, использующих эти же инструменты.

Одной рукой — создавать Veo. Другой — блокировать доходы с контента, сделанного через него.Это не стратегия. Это корпоративная шизофрения.

Что это значит для авторов

- Полностью сгенерированный контент — под запретом на монетизацию

- ИИ-голос за кадром — повод для отключения рекламы

- Нарушения — даже без страйков, YouTube просто выключит доход

YouTube рекомендует авторам «использовать ИИ только как вспомогательный инструмент» и обязательно указывать степень его участия в описании. Но при этом не объясняет, как отличить «вспомогательный» от «слишком ИИ».

Что дальше

YouTube пытается вернуть контроль, но запаздывает: миллионы аккаунтов уже построили бизнес на потоковом ИИ-контенте. Теперь им придётся перестраиваться — или искать площадки попроще.

Один технологический гигант выпустил нейросеть. Второй — разрешил её использовать. А третий — отобрал монетизацию. И всё это один и тот же Google.